实验室硕士研究生李文强一篇论文被ICLR2023接收

时间:2023-03-15近日,人工智能国际顶级会议ICLR 2023公布论文录用名单,课题组2021级硕士研究生李文强的学术论文《Transformer-based model for symbolic regression via joint supervised learning》被录用。国际表征学习大会(International Conference on Learning Representations,简称ICLR)是人工智能领域的国际顶级会议,在Google Scholar人工智能领域的学术会议/期刊中排名第一位(h5指数)。会议关注深度学习各个方面的前沿研究,在世界范围内每年召开一次,本届会议共收到投稿约5000篇,录用率为31.8%。

论文《Transformer-based model for symbolic regression via joint supervised learning》的第一作者为2021级硕士研究生李文强,通讯作者为李卫军研究员。

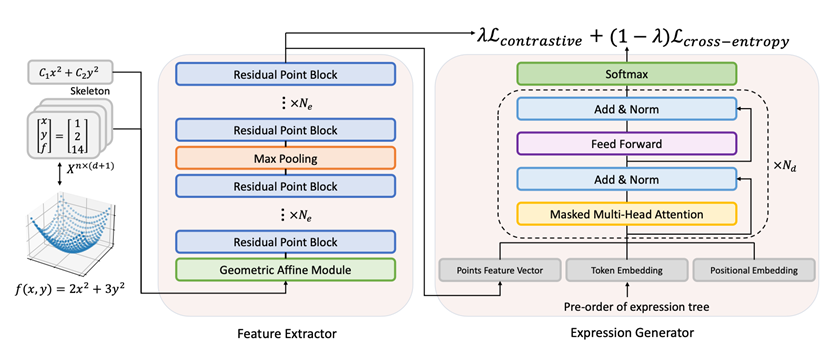

本文模型学习架构图

本文在符号回归领域作出创新研究。符号回归是一项重要的机器学习方法,其目的是探索能够较好拟合观测数据的数学表达式模型,与多项式拟合或神经网络拟合不同的是,符号回归不需要事先对数学模型做任何先验假设,得到的简洁的数学表达式可以直观地反映数据输入与输出之间的内在规律和联系,其内部机理可知,可解释性与泛化能力强。近期相关的研究成果集中在使用大规模数据对符号回归任务进行建模,由于数学表达式中符号与系数强耦合的特点,本文指出此类方法中由于监督信息不足而导致的ill-posed问题,提出一种求解更精确更高效的符号回归框架。本文重新审视使用监督学习建模数据点空间与符号空间的映射关系,推导出加权形式的监督学习优化目标,引入有监督的对比学习目标,使用点云模型与Transformer进行建模,有效缓解了该类方法存在的ill-posed问题。为了评估符号回归算法的性能,本文开源了一个基准数据集,其中包含多个相同表达式骨架不同系数的表达式。实验结果表明,本文提出的符号回归算法在多个公共数据集上优于当前的基线算法,尤其是在推理相同骨架系数不同的表达式中优势最为显著。